I buchi neri sono un argomento molto complesso. Per descriverli compiutamente e raccontare del loro impatto sugli studi del cosmo non basterebbe una enciclopedia, figuriamoci le poche pagine di un blog. Parafrasando la celebre frase — forse apocrifa anch’essa come la celebre mela di Newton — del grande Galileo: “Eppur ci provo” …

Volete fare un viaggio in prossimità dell’orizzonte degli eventi? Ecco una plausibile simulazione. Cliccate sulla figurina in basso a destra.

Senza ombra di dubbio i buchi neri sono tra gli oggetti astrofisici più noti e studiati nel dettaglio. Nessuno ha mai realmente visto un buco nero, ma grazie alla Relatività Generale se ne conoscono talmente bene gli effetti che esso ha sul tessuto dello spazio-tempo circostante che oggi è possibile cercare nel Cosmo i segni della loro presenza e descriverli graficamente.

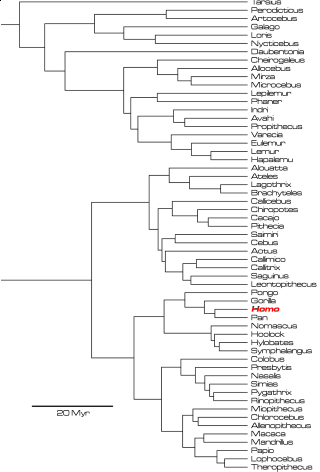

Dai nuclei delle galassie AGN fino ai resti di stelle massicce collassate e ancora più giù fino agli ipotetici micro buchi neri formatisi col Big Bang, si può dire che non c’è quasi limite alle dimensioni che questi oggetti possono raggiungere [cite]https://arxiv.org/abs/astro-ph/9605152[/cite].

Il Principio Olografico

L’entropia (misura dell’informazione nascosta) di un buco nero, misurata in bit, è proporzionale all’area del suo orizzonte degli eventi misurata in unità di Planck

Jacob Bekenstein

Per comprendere l’interpretazione olografica dell’orizzonte degli eventi di un buco nero, occorre prima ripetere ciò che avevo accennato nella scorsa puntata, ossia se un buco nero distrugga o meno l’informazione riguardante tutto ciò che finisce oltre il suo orizzonte degli eventi — ricordo che questo è più un concetto matematico più che un oggetto tangibile.

Secondo Shannon i concetti di entropia e di informazione si equivalgono e, come anche Leonard Susskind ha ribadito, l’entropia non è altro che la misura delle informazioni nascoste, cioè quelle che a noi non sono note. Se infatti le conoscessimo potremmo ricostruire l’evento che le ha generate, come ad esempio possiamo risalire alla massa, traiettoria ed energia di una particella coinvolta in una collisione in una camera a bolle semplicemente ripercorrendo a ritroso la storia degli eventi che essa ha scatenato.

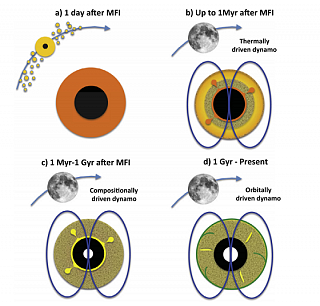

Il teorema della complementarietà dei buchi neri fu proposto da Susskind (anche questo concetto è mutuato da altre teorie, in questo caso dalla meccanica quantistica) per risolvere il paradosso dell’informazione perduta dentro un buco nero. Qui per l’osservatore A l’astronauta varcherebbe l’orizzonte degli eventi di un buco nero ma verrebbe distrutto mentre tutta la sua informazione verrebbe distribuita su tutta la superficie dell’orizzonte degli eventi. Invece per l’osservatore B oltre l’orizzonte o per lo stesso astronauta l’attraversamento dell’orizzonte avverrebbe senza particolari fenomeni di soglia, come già descritto nel primo articolo.

Come ho cercato di spiegare nelle precedenti puntate tutta l’entropia — o informazione nascosta equivalente — di un buco nero può solo risiedere sulla superficie degli eventi come microstati — o bit — grandi quanto il quadrato della più piccola unità di misura naturale, ossia la lunghezza di Plank 1. Questo significa che tutta l’informazione di tutto ciò che è, od è finito, oltre l’orizzonte degli eventi, è nascosta nella trama dell’orizzonte degli eventi stesso. Potessimo interpretare compiutamente questa informazione, idealmente potremmo risalire alla sua natura.

In base a questa interpretazione tutto ciò che è contenuto in una data regione di spazio può essere descritto dall’informazione confinata sul limite della stessa, così come la mia mano è descritta da ciò che di essa percepisco dalla superficie dello spazio che occupa.

In pratica quindi l’informazione tridimensionale di un qualsiasi oggetto è contenuta su una superficie bidimensionale, che nel caso dei buchi neri, è rappresentata dall’orizzonte degli eventi 2.

L’analogia col fenomeno a noi più familiare è quella dell’ologramma, dove tutte le informazioni spaziali riguardanti un oggetto tridimensionale qualsiasi sono impresse su una superficie bidimensionale. Osservando l’ologramma noi effettivamente percepiamo le tre dimensioni spaziali, possiamo ruotare l’immagine, osservarla da ogni sua parte etc., ma essa comunque trae origine dalle informazioni impresse su una superficie bidimensionale; la terza dimensione percepita emerge 3 dalla combinazione di tutte le informazioni lì racchiuse.

Conclusioni

Il Principio Olografico è questo: un modello matematico che tenta di conciliare la Termodinamica e la meccanica della Relatività Generale dei buchi neri, due leggi che finora si sono dimostrate universalmente esatte e che nel caso specifico dei buchi neri sembrano violarsi.

Questo modello è reso ancora più intrigante per le sue particolari previsioni teoriche: dalla validità della Teoria delle Stringhe alla Super Gravità Quantistica passando per le teorie MOND (Modified Newtonian Dynamics) che potrebbero addirittura dimostrare l’inesistenza della materia e dell’energia oscure.

Addirittura il Principio Olografico potrebbe essere usato per suggerire che l’intero nostro Universo è in realtà un buco nero provocato dal collasso di una stella di un superiore universo a cinque dimensioni, ci sono studi al riguardo [cite]https://www.scientificamerican.com/article/information-in-the-holographic-univ/[/cite] [cite]https://arxiv.org/abs/1309.1487[/cite].

Cercherò in futuro di trattare questi argomenti, sono molto intriganti.