Anche se in merito sono state fatte le diverse e più disparate ipotesi, dalla radiazione polarizzata di una supernova vicina nel periodo della nascita della vita sulla Terra fino alla radiazione di una pulsar ormai spersa e forse estinta che investiva il pianeta sempre in quei momenti, nessuna di queste è a mio avviso abbastanza libera da eventi dovuti al caso. Probabilmente l’origine dell’omochiralità levogira degli aminoacidi necessari alla vita è dovuta a fattori più fondamentali e universali.

[latexpage]

Tutti gli aminoacidi e molte altre molecole – isomeri – hanno un aspetto diverso se invertite spazialmente. Tutta la vita che conosciamo è capace di utilizzare solo una delle due immagini; in genere la versione levogira per quanto riguarda gli aminoacidi e la versione destrogira per i glucidi. Queste molecole complesse esistono in due forme speculari e non sovrapponibili dette enantiomeri che, in base alla disposizione spaziale in tre dimensioni degli atomi, vengono definite destro o levogire per la loro capacità di ruotare il piano della luce polarizzata 1. A parte questa apparente sottigliezza, entrambi gli enantiomeri hanno sostanzialmente le stesse proprietà fisiche 2. Però, in certe reazioni o strutture, è utilizzabile solo l’una o l’altra forma. La principale funzione di particolari proteine (macromolecole biologiche formate da sequenze di aminoacidi legate tra loro) dette enzimi, è quella di catalizzare le reazioni biomolecolari, tra cui la sintesi delle altre proteine. La capacità catalitica degli enzimi dipende criticamente dalla loro struttura tridimensionale, la quale a sua volta dipende dalla direzione della sequenza degli aminoacidi. Catene sintetiche di amminoacidi formate sia da enantiomeri levogiri sia da enantiomeri destrorsi in una miscela 1:1, detta racemo, non si avvolgono nel giusto modo per produrre un’efficace attività catalitica; esse sono incapaci di formare una regolare struttura elicoidale. Il DNA, ad esempio, è composto da basi azotate, glucidi e fosfati racchiusi in strutture chiamate nucleotidi le quali compongono la celebre doppia elica: che qui è sempre destrorsa.

Tutti gli aminoacidi e molte altre molecole – isomeri – hanno un aspetto diverso se invertite spazialmente. Tutta la vita che conosciamo è capace di utilizzare solo una delle due immagini; in genere la versione levogira per quanto riguarda gli aminoacidi e la versione destrogira per i glucidi. Queste molecole complesse esistono in due forme speculari e non sovrapponibili dette enantiomeri che, in base alla disposizione spaziale in tre dimensioni degli atomi, vengono definite destro o levogire per la loro capacità di ruotare il piano della luce polarizzata 1. A parte questa apparente sottigliezza, entrambi gli enantiomeri hanno sostanzialmente le stesse proprietà fisiche 2. Però, in certe reazioni o strutture, è utilizzabile solo l’una o l’altra forma. La principale funzione di particolari proteine (macromolecole biologiche formate da sequenze di aminoacidi legate tra loro) dette enzimi, è quella di catalizzare le reazioni biomolecolari, tra cui la sintesi delle altre proteine. La capacità catalitica degli enzimi dipende criticamente dalla loro struttura tridimensionale, la quale a sua volta dipende dalla direzione della sequenza degli aminoacidi. Catene sintetiche di amminoacidi formate sia da enantiomeri levogiri sia da enantiomeri destrorsi in una miscela 1:1, detta racemo, non si avvolgono nel giusto modo per produrre un’efficace attività catalitica; esse sono incapaci di formare una regolare struttura elicoidale. Il DNA, ad esempio, è composto da basi azotate, glucidi e fosfati racchiusi in strutture chiamate nucleotidi le quali compongono la celebre doppia elica: che qui è sempre destrorsa.

Ogni produzione spontanea 3 di aminoacidi ottenuta in laboratorio da luogo sempre a una soluzione racemica mentre le catene proteiche degli esseri viventi che conosciamo utilizzano esclusivamente forme levogire.

Il problema dell’omichiralità degli isomeri necessari alla vita non è mai stata risolta del tutto. Alcuni ritengono che questa sia frutto della selezione entropica naturale [cite]http://dx.doi.org/10.2174/187231308784220536[/cite] che pare favorisca la selezione delle migliori soluzioni di trasduzione dell’energia disponibili. In questo una soluzione enantiopura è decisamente migliore di una racemica, come dimostrano altri studi [cite]http://pubs.acs.org/doi/abs/10.1021/jp046478x[/cite], ma tutti questi studi pur dimostrando la necessità della vita di scegliere per l’omochiralità non spiegano perché per gli aminoacidi sia stato scelto il modello levogiro e destrogiro per gli zuccheri.

Una plausibile spiegazione viene dalle riflessioni di Frederic Vester e Tilo L. V. Ulbricht del 1957, i quali sospettarono la appena scoperta Violazione della Parità prodotta dall’Interazione Debole negli atomi [cite]10.1016/S0040-4020(01)92714-0[/cite] di essere responsabile dell’omochiralità a ogni scala. o quasi..

La simmetria P

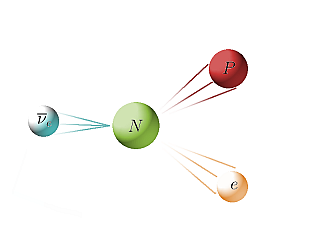

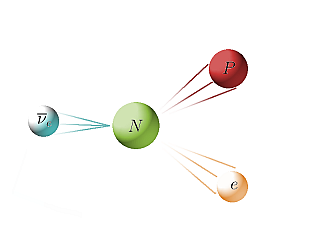

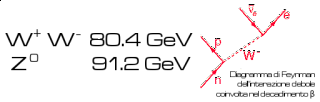

L’interazione debole di un antineutrino elettronico con un neutrone all’interno di un nucleo atomico può spingerlo a decadere in un protone e un elettrone. Credit Il Poliedrico.

In fisica si chiama Simmetria P, simmetria di trasformazione di parità 4. Quasi tutte le leggi fisiche fondamentali rispettano questa regola. L’elettromagnetismo, la forza di gravità e l’interazione nucleare forte rispettano tale simmetria, ossia sono invarianti rispetto all’inversione delle coordinate spaziali (potremmo immaginare lo stesso fenomeno come visto riflesso allo specchio procedere verso il medesimo risultato che nel mondo reale, solo che è appunto invertito spazialmente). La più debole delle quattro interazioni, l’interazione debole, invece no. Anzi è proprio lei la causa della violazione della Simmetria P.

Come dice il suo nome, l’interazione debole è veramente debole: circa 1000 volte meno intensa della forza elettromagnetica e 100 000 volte meno intensa della forza nucleare forte. L’interazione debole è responsabile sia per la fusione nucleare delle particelle subatomiche che per l’emissione di raggi beta durante il decadimento radioattivo. I raggi beta sono in realtà elettroni o positroni ad alta energia espulsi da un nucleo atomico durante il decadimento beta ($\beta$). Queste particelle hanno uno spin intrinseco e quindi, quando si muovono lungo il loro asse di spin, si possono classificare come sinistrorsi o destrorsi. La violazione della parità indica che le particelle beta emesse dai nuclei radioattivi mostrano segni evidenti di una asimmetria chirale: le particelle sinistrorse emesse durante il decadimento superano di gran lunga quelli destrorse.

Durante il decadimento beta vengono emesse anche altre particelle elettricamente neutre – il neutrino e l’antineutrino – che si propagano quasi alla velocità della luce. Come l’elettrone, l’antineutrino emesso dalla materia radioattiva ha uno spin ma, diversamente dall’elettrone, esiste solo nella forma destrorsa. Pare che nell’universo non esistano neutrini destrorsi e antineutrini sinistrorsi.

Chiralità Quantistica

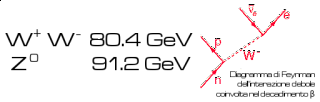

Il Modello Standard delle particelle elementari, unisce le leggi dell’eletttromagnetismo di Maxwell e l’interazione debole in un’unica forza, l’Interazione Elettrodebole e introduce il concetto di correnti deboli cariche e le correnti deboli neutre mediate dai bosoni $W^\pm$ e $Z^0$. L’opera di queste correnti , o forze, tra due particelle elementari dipende dalla distanza tra le particelle, dalla loro carica elettrica e dalla direzione del loro spin. L’elettrone ha una carica elettrica negativa e la forza elettrica tra due elettroni qualsiasi è sempre repulsiva. Invece, la carica debole $W$ è non nulla per un elettrone sinistrorso e nulla per uno destrorso. Quindi, un elettrone destrorso si limita semplicemente a non percepire la forza $W$. La corrente debole neutra $Z$ invece agisce sullo spin, elettroni sinistrorsi e destrorsi hanno cariche $Z$ di segno opposto e di intensità circa uguale. La differenza di segno provoca l’attrazione degli elettroni destrorsi verso il nucleo da parte della corrente $Z$ e la repulsione di quelli sinistrorsi 5 6. È per questo che il decadimento nucleare beta, dominato dalle correnti deboli, produce un eccesso di elettroni sinistrorsi. Se non fosse violata la parità, in un mondo visto allo specchio il decadimento beta produrrebbe elettroni destrorsi e la corrente debole neutra $Z$ attirerebbe verso il nucleo anche gli elettroni sinistrorsi. Questi processi non si osservano però nel mondo reale, il che è un altro modo per affermare che la forza debole è chiralmente asimmetrica e che la parità non viene conservata.

Il Modello Standard delle particelle elementari, unisce le leggi dell’eletttromagnetismo di Maxwell e l’interazione debole in un’unica forza, l’Interazione Elettrodebole e introduce il concetto di correnti deboli cariche e le correnti deboli neutre mediate dai bosoni $W^\pm$ e $Z^0$. L’opera di queste correnti , o forze, tra due particelle elementari dipende dalla distanza tra le particelle, dalla loro carica elettrica e dalla direzione del loro spin. L’elettrone ha una carica elettrica negativa e la forza elettrica tra due elettroni qualsiasi è sempre repulsiva. Invece, la carica debole $W$ è non nulla per un elettrone sinistrorso e nulla per uno destrorso. Quindi, un elettrone destrorso si limita semplicemente a non percepire la forza $W$. La corrente debole neutra $Z$ invece agisce sullo spin, elettroni sinistrorsi e destrorsi hanno cariche $Z$ di segno opposto e di intensità circa uguale. La differenza di segno provoca l’attrazione degli elettroni destrorsi verso il nucleo da parte della corrente $Z$ e la repulsione di quelli sinistrorsi 5 6. È per questo che il decadimento nucleare beta, dominato dalle correnti deboli, produce un eccesso di elettroni sinistrorsi. Se non fosse violata la parità, in un mondo visto allo specchio il decadimento beta produrrebbe elettroni destrorsi e la corrente debole neutra $Z$ attirerebbe verso il nucleo anche gli elettroni sinistrorsi. Questi processi non si osservano però nel mondo reale, il che è un altro modo per affermare che la forza debole è chiralmente asimmetrica e che la parità non viene conservata.

Chiralità molecolare

Pozze di fango, comete e sacche di polvere interstellare. Ecco dove possono nascere i mattoni della Vita. Credit: Il Poliedrico

Come conseguenza dell’interazione debole, gli atomi, finora pensati achirali, mostrano invece di possedere una distinzione tra destra e sinistra. Questa distinzione se è presente su scala atomica, potrebbe riflettersi su scale di ordine superiore? C’è da aspettarsi che anche le strutture molecolari più complesse, come ad esempio gli aminoacidi, mostrino proprietà fisiche differenti in base alla loro chiralità. L’asimmetria chirale a livello subatomico ha origine a livello fondamentale con la violazione della parità. Su scala superiore la corrente debole neutra $Z$ fa sì che che una molecola chirale abbia stati energetici diversi tra i due isomeri.

Per comprendere meglio questo meccanismo, immaginiamo una molecola chirale come un’elica o una vite e supponiamo che la corrente $Z$ non esista. Un elettrone con spin $\uparrow$ che si muove nello stesso senso dell’elica $\uparrow$ è destrorso, mentre è sinistrorso se si muove nel senso contrario. Dal punto di vista probabilistico però dovremmo comunque aspettarci che la chiralità media degli elettroni sia nulla; però le correnti elettromagnetiche presenti nell’atomo tendono a far allineare l’asse orbitale dell’elettrone nel senso opposto al suo spin. Questo fenomeno, noto come accoppiamento spin-orbita, tende a far allineare l’elettrone nel moto opposto al suo spin in una molecola chirale destrorsa, per cui in questo caso gli elettroni tendono ad essere sinistrorsi. Invece negli enantiomeri levogiri sono gli elettroni destrorsi a prevalere. Ora tornando a prendere in considerazione anche la corrente debole neutra $Z$, che interagisce con gli elettroni in modi dipendenti dalla loro chiralità, viene fuori che essa provoca una diversità energetica tra due enantiomeri opposti [cite]http://pubs.rsc.org/en/content/articlelanding/1983/c3/c39830000117#!divAbstract[/cite].

Come è facile intuire, l’enantiomero levogiro degli aminoacidi- che è quello biologicamente più dominante – è anche quello che possiede l’energia molecolare più bassa (gli elettroni dominanti sono destrorsi), mentre al contrario è l’enantiomero destrorso il più energetico.

Tutto questo è sostanzialmente in accordo con i principi della statistica e della termodinamica che in caso di sostanziale equilibrio è la forma con l’energia più bassa a prevalere; è stato calcolato che la discrepanza nella produzione spontanea dei due isomeri è così minuscola da passare inosservata: una parte su 10^17.

Un’altra fonte dell’omochiralità è il decadimento $\beta$. Nell’ipotesi Vester-Ulbricht si sostiene che durante il decadimento spontaneo viene emessa una debole traccia elettromagnetica, un Effetto Bremsstrahlung 7 interno all’atomo [cite]10.1016/S0031-8914(36)80008-1[/cite]. Questa emissione ha la stessa polarizzazione della particella che la emette. Per gli effetti dell’interazione elettrodebole che abbiamo visto più sopra, la maggior parte, circa l’80%, degli elettroni emessi durante il decadimento sono sinistorsi, e così è anche per la radiazione. Gli effetti della radiazione polarizzata è che essa tende a distruggere le molecole chirali dello stesso ordine, così una polarizzazione sinistrorsa tende a distruggere le molecole sinistrorse, ma il contributo della radiazione Bremsstrahlung interna è veramente molto piccolo; si calcola invece che l’interazione diretta della radiazione $\beta$ (elettroni e positroni) sui due isomeri sia comunque solo di una parte su 10^11. Un importante sostegno a questa teoria viene dai risultati di un recente studio che mostra un legame significativo tra l’energia degli elettroni diversamente polarizzati e l’evoluzione chirale della bromocanfora [cite]http://dx.doi.org/10.1103/PhysRevLett.113.118103[/cite].

Ecco quindi sostanzialmente spiegato come mai ogni produzione spontanea di aminoacidi in laboratorio (ex. gli esperimenti di Stanley e Urey) porta sempre a una sostanziale soluzione racemica.

Ma una scappatoia al racemo c’è. Come insegna la termodinamica, un sistema chiuso tende sempre ad evolversi verso uno stato di equilibrio di minima energia, dove le concentrazioni molecolari sono definite dalla loro energia ed entropia. Trascurando la diversità energetica tra i due enantiomeri dovuta dalle correnti nucleari deboli, differenza reale ma comunque piccolissima, un sistema chiuso quindi può solo evolversi verso un sistema chiralmente simmetrico dove gli isomeri levogiri e destrorsi sono presenti in uguale proporzione. In un sistema aperto all’ingresso di nuova materia ed energia invece non è raggiungibile un equilibrio termodinamico; al suo posto accade un fenomeno chiamato rottura di simmetria, che porta alla predominanza spontanea di uno dei due enantiomeri sull’altro. Anche in questo caso gli gli stessi principi statistici e termodinamici suggeriscono che siano gli enantiomeri levogiri degli aminoacidi a prevalere.

E come la mano sinistra si intreccia meglio con la destra, anche i glucidi di conseguenza hanno subito la loro selezione: per adattarsi meglio agli aminoacidi levogiri i glucidi hanno subito un’evoluzione complementare fino a produrre strutture elicoidali destrorse, precursori del DNA.

Conclusioni

L’idea che l’omochiralità delle forme più complesse possa trarre origine dalle leggi più fondamentali della natura è veramente attraente.

Non occorrerebbe più attendere – o dimostrare – che un sorgente di radiazioni polarizzata illumini un mondo promettente per ottenere la scintilla omochirale. Elettroni sinistrorsi prodotti dal decadimento $\beta$ di isotopi prodotti dalle supernovae sono senza dubbio un fonte universale di radiazione polarizzata capace di condizionare gli isomeri ovunque: dagli asteroidi alle comete ghiacciate nelle nubi di Oort di di ogni sistema stellare; dai fondali di oceani alieni a pozze di fango su mondi appena formati fino ad arrivare anche alle nubi interstellari e ai globuli di Bok.

Se l’ipotesi che le radici dell’omochiralità sono nell’Interazione Elettrodebole fosse corretta, dimostrerebbe che le fondamenta della Vita sono più legate alla struttura fondamentale dell’Universo di quanto finora si pensi. Una gran bella idea!

Note:

Giorni fa avevo delle faccende da sbrigare a Ciampino — per chi non è pratico dico che è vicino a Roma, poco prima di Frascati — ma essendo in netto anticipo, decido di passar a fare visita a un mio caro amico presso l’osservatorio astronomico di Monte Porzio Catone. Non conoscendo esattamente la strada, come ormai tutti siamo abituati a fare ho semplicemente digitato la località di destinazione sul navigatore satellitare dell’auto e mi sono lasciato guidare fino a destinazione.

Giorni fa avevo delle faccende da sbrigare a Ciampino — per chi non è pratico dico che è vicino a Roma, poco prima di Frascati — ma essendo in netto anticipo, decido di passar a fare visita a un mio caro amico presso l’osservatorio astronomico di Monte Porzio Catone. Non conoscendo esattamente la strada, come ormai tutti siamo abituati a fare ho semplicemente digitato la località di destinazione sul navigatore satellitare dell’auto e mi sono lasciato guidare fino a destinazione.