Tutti in questo periodo si abbandonano alle previsioni. Oroscopi, previsioni sportive, meteorologiche o di mercato 1 e, per quest’anno, ci si mettono pure i Maya con il loro calendario a termine il 23 dicembre prossimo venturo come una mozzarella a lunga conservazione!

Nell’attesa di assaggiare il prossimo panettone di Natale mi lancio anch’io per una volta nella moda delle previsioni e siccome più che sapere di essere un cattivo veggente sono soprattutto pigro nello scrivere, mi fermerò ad aprile (almeno la S. Pasqua i Maya ci permettono di festeggiarla):

Premesso che per quest’anno se rimarrete in Italia scordatevi le eclissi come abbiamo avuto quest’anno che sta per terminare, vediamo cosa ci offre il cielo nel 2012 e nel mese di

Gennaio:

Intanto informo i più temerari (l‘ho già detto: io sono pigro e freddoloso come tutti i vecchietti di questo mondo, quindi me ne starò a letto) che la prima metà del mese sarà dominata dallo sciame delle Quadrantidi, anche se la Luna Piena il giorno 7 disturberà non poco l’osservazione di questo ricco sciame; se vedrete una stella cadente in questo periodo mandate un pensierino agli jettatori della fine del mondo.

Il 2 del mese offrirà una bella congiunzione di Giove-Luna (poco dopo il 1° quarto) la cui distanza apparente sarà inferiore ai 5 gradi; non sarà poi molto, ma è pur sempre un bel colpo d’occhio.

Febbraio:

Il mese non offrirà spunti particolarmente significativi, tranne forse che la Luna passerà vicino ad Aldebaran il giorno 2 e incontrerà Spica il 12 del mese in linea con Saturno.

Marzo:

Il 5 Mercurio sarà alla sua massima elongazione est – sarà visibile quindi al tramonto – in fila assieme a Giove (in alto) e Venere (nel mezzo). Una danza quella dei pianeti più luminosi che culminerà nella congiunzione del giorno 14, mentre il 24, cielo permettendo, al tramonto ritroveremo Venere e Giove e una sottilissima falce di Luna; questo sì che che sarà bello ammirare.

Intanto si preparano le condizioni per l’evento clou di questo primo quarto di anno: il 27 marzo Venere sarà alla massima elongazione est. Questo significa che sta per avvicinarsi alla Terra e, nonostante la sua falce illuminata rivolta verso di noi si stia assottigliando, per il breve periodo di circa un mese sarà estremamente luminosa: -4,5 / -4,7 di magnitudine!

Infatti ad aprile Venere sarà particolarmente luminosa, specie nei giorni attorno il 20 -25 aprile. Il 21 sarà Luna Nuova e il 22 sarà all’apogeo.

Quindi quali condizioni migliori per sperare di riuscire a vedere e fotografare l’Ombra di Venere 2?

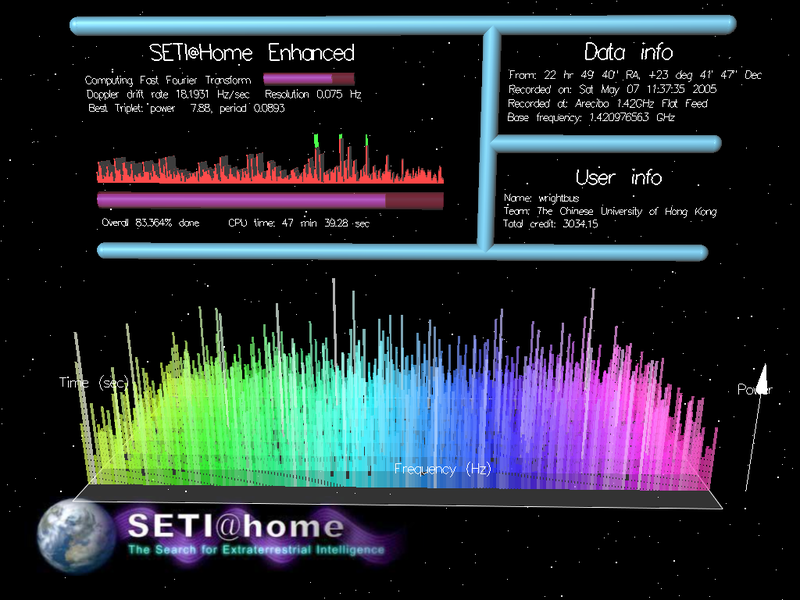

Le osservazioni dei prossimi due anni consentiranno l’esplorazione sistematica dei pianeti scoperti di Kepler nella finestra delle microonde da 1-10 GHz. L’ATA è l’unico radiotelescopio che può fornire l’accesso immediato a decine di milioni di canali in qualsiasi momento e ovunque in questa fascia di ben 9 miliardi di canali (ogni canale è largo appena un 1 Hz!).

Le osservazioni dei prossimi due anni consentiranno l’esplorazione sistematica dei pianeti scoperti di Kepler nella finestra delle microonde da 1-10 GHz. L’ATA è l’unico radiotelescopio che può fornire l’accesso immediato a decine di milioni di canali in qualsiasi momento e ovunque in questa fascia di ben 9 miliardi di canali (ogni canale è largo appena un 1 Hz!).

dove

dove